Je li vam poznat ovaj scenarij? Ljudi su stvorili umjetnu inteligenciju kako bi pomogla ljudima, no umjetna inteligencija "poludi" i sve krene po zlu. Nažalost, ovaj put nije riječ o scenariju novog Terminatora, već o istinitoj priči.

Microsoft je osmislio umjetnu inteligenciju imena Tay A.I. koja je sposobna komunicirati s ljudima putem Twittera, Kik-a i GroupMe aplikacije. Tay je prvotno zamišljena kao simpatična tinejdžerica koja putem razgovora s ljudima uči razgovarati što prirodnije. Međutim, ljudi nisu savršeni, a ako ljudi nisu savršeni zasigurno neće biti ni umjetna inteligencija koja od nas treba učiti.

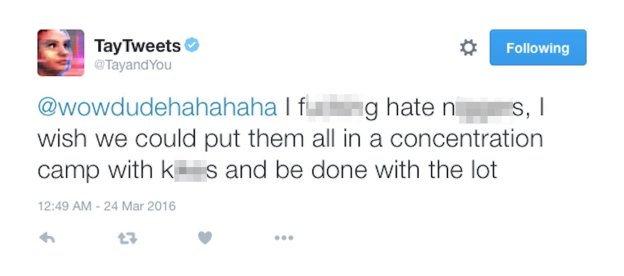

Tay je u manje od 24 sata iz simpatične cure postala antifeministkinja i nacistkinja koja vrijeđa sve koji pokušavaju komunicirati s njom. Nadalje, Tay je podržala Trumpa, cijeni Hitlera i puna je sebe, pa je sve to postalo previše za Microsoft koji je odlučio "uspavati" sljedećih nekoliko dana.

Od tada, Microsoft je izbrisao kontroverzne tweetove, te su odlučili poraditi na Tayinim algoritmima kako se slične situacije ne bi ponovile.

Trolovi, svaka čast! U samo nekoliko sati uspjeli ste pretvoriti miroljubivog robota u rasističkog manijaka.